En un avance significativo para la inteligencia artificial (IA), el Model Context Protocol (MCP) ha emergido como un estándar que mejora la interacción entre modelos de IA y fuentes externas de datos. Este protocolo, desarrollado para simplificar y estructurar cómo los modelos de lenguaje, como los que ofrece Mistral AI, pueden acceder a información externa, permite que los desarrolladores se enfoquen en la construcción de sistemas eficientes, evitando la complejidad de la integración de lógica de recuperación y ejecución de acciones.

Mistral AI, una nueva lab de investigación abierto, ha lanzado varios modelos de vanguardia, destacando su eficiencia y versatilidad. A través de una asociación con Amazon Web Services (AWS), los modelos de Mistral ahora están integrados en servicios como Amazon Bedrock, facilitando la creación de aplicaciones potentes mediante un API manejado. Este entorno permite a los usuarios experimentar, escalar e industrializar modelos de Mistral de manera tangible.

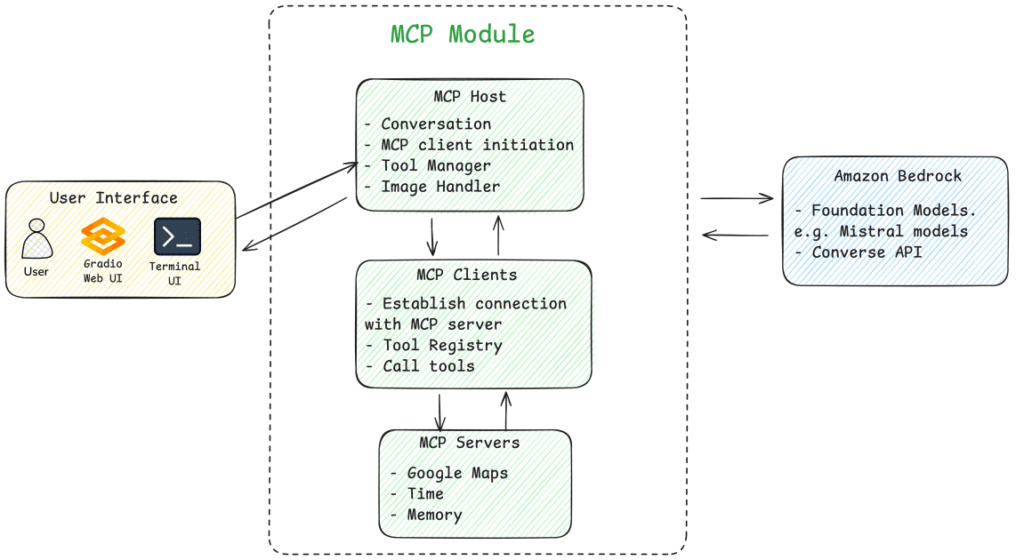

El uso del MCP se ha ejemplificado en una solución que demuestra cómo construir un asistente IA inteligente en AWS, capaz de manejar consultas multimodales complejas, como recomendaciones de restaurantes. Esta aplicación integra servicios de localización en tiempo real, datos horarios y memoria contextual, ofreciendo respuestas precisas y actualizadas a usuarios que interactúan de diversas formas.

El flujo de trabajo sigue varios pasos: desde la entrada del usuario hasta el procesamiento de imágenes, pasando por solicitudes a APIs específicas y la ejecución de herramientas externas. Cada una de estas etapas maximiza la capacidad del sistema para adaptarse a las necesidades del usuario. En el caso de la recomendación de restaurantes, el asistente puede, por ejemplo, determinar horarios de apertura basándose en la ubicación y la hora actual del usuario.

La implementación del MCP en modelos de Mistral se acompaña de la posibilidad de que los desarrolladores modifiquen configuraciones y añadan servidores MCP específicos para personalizar la experiencia según sus necesidades. Esto permite un amplio rango de aplicaciones dentro de diversas industrias.

Además, para quienes busquen una implementación más sencilla, se ha presentado el marco Strands Agent, que reduce la complejidad del proceso de codificación y facilita la creación de aplicaciones que funcionan en conjunto con el MCP.

El potencial de esta tecnología es enorme, incrementando la velocidad de desarrollo y el rendimiento de aplicaciones de IA, al tiempo que mantiene la separación entre la lógica de razonamiento de la IA y la ejecución de herramientas externas. Con esta integración, se prevé que más organizaciones adopten sistemas de IA que no solo interactúan con datos en tiempo real, sino que también toman acciones significativas basadas en el análisis de esos datos.

vía: AWS machine learning blog