OpenAI ha lanzado dos nuevos modelos de pesos abiertos, gpt-oss-120b y gpt-oss-20b, que cuentan con 117 mil millones y 21 mil millones de parámetros, respectivamente. Estos modelos, diseñados con un enfoque de Mezcla de Expertos (MoE) y una ventana de contexto de 128K, han sido reconocidos como los líderes en modelos de código abierto según los benchmarks de Artificial Analysis, destacándose en tareas de razonamiento y flujos de trabajo dinámicos.

A través de Amazon SageMaker AI, los usuarios pueden personalizar y afinar estos modelos, así como desplegarlos según su preferencia de marco mediante un servicio completamente gestionado. La flexibilidad ofrecida por Amazon SageMaker Inference permite incorporar código de inferencia propio sin necesidad de construir y mantener clústeres.

A pesar de que los grandes modelos de lenguaje (LLMs) son excelentes en la comprensión del lenguaje y la generación de contenido, la creación de aplicaciones del mundo real que actúan de manera autónoma implica una gestión compleja de flujos de trabajo, capacidades de llamada a herramientas y gestión del contexto. Las arquitecturas de múltiples agentes contribuyen a abordar estos desafíos descomponiendo sistemas complejos en componentes especializados, aunque también plantean nuevas complejidades en la coordinación de agentes y la orquestación de flujos de trabajo.

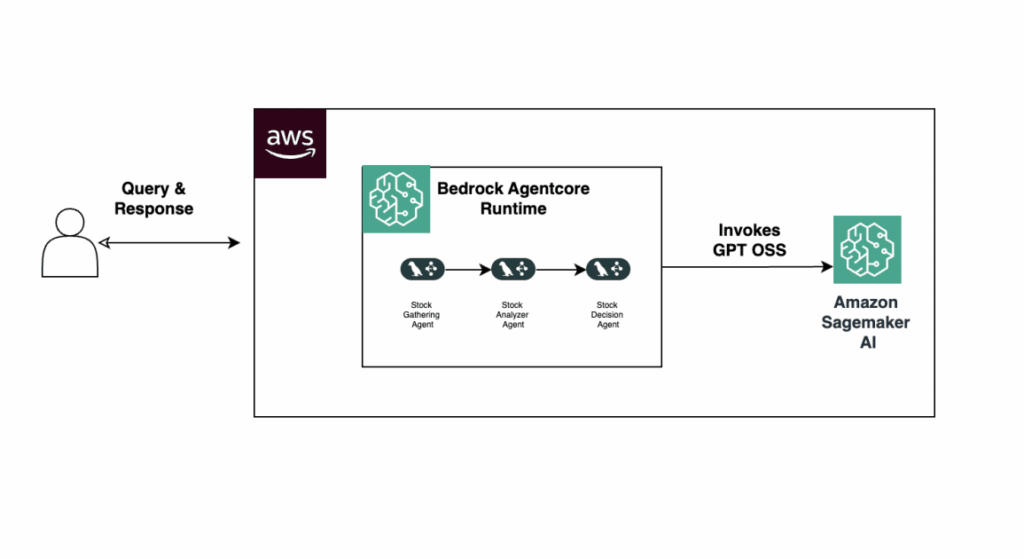

En un reciente post, se explica cómo desplegar el modelo gpt-oss-20b en los endpoints gestionados de SageMaker y se presenta un ejemplo práctico de asistente analizador de acciones usando LangGraph, un potente marco basado en gráficos que maneja la gestión de estado y flujos de trabajo coordinados. Después, los agentes se desplegarán en Amazon Bedrock AgentCore, una capa de orquestación unificada que abstrae la infraestructura, permitiendo la operación segura de agentes de IA a gran escala.

La solución construida consiste en un analizador de acciones con componentes clave: el modelo GPT OSS 20B desplegado en un endpoint de SageMaker mediante vLLM; LangGraph para construir un marco de orquestación de múltiples agentes; y Amazon Bedrock AgentCore para el despliegue de agentes. La arquitectura de esta solución es fácilmente observable y permite que un usuario someta una consulta que será manejada por una serie de agentes especializados en la evaluación de acciones.

Además, los usuarios son guiados sobre cómo configurar sus entornos, gestionar permisos y realizar despliegues eficientes, enfatizando la importancia de herramientas como vLLM y Amazon Elastic Container Registry para un proceso de hospedaje fluido. Todo esto contribuye a reducir el tiempo de análisis de acciones y a aumentar la productividad de los analistas al automatizar tareas rutinarias, liberando recursos valiosos para enfoques más complejos y estratégicos en el ámbito empresarial.

Se invita a explorar ejemplos de código y a iterar sobre flujos de trabajo de agentes para satisfacer distintos casos de uso, destacando el potencial de los modelos de código abierto en la optimización de procesos.

vía: AWS machine learning blog