Desplegar modelos de aprendizaje automático (ML) en producción es una tarea que puede complicarse y requerir muchos recursos, especialmente para aquellos clientes que no cuentan con experiencia profunda en ML y DevOps. Amazon SageMaker Canvas ofrece una solución facilitada al simplificar la construcción de modelos mediante una interfaz de no-código, permitiendo a los usuarios crear modelos de ML altamente precisos utilizando sus fuentes de datos existentes, sin necesidad de escribir código. Sin embargo, la creación del modelo es solo la mitad del proceso; su implementación eficiente y económica es igual de crucial.

Amazon SageMaker Serverless Inference está diseñado para cargas de trabajo con patrones de tráfico variables y períodos de inactividad. Este servicio gestiona automáticamente la provisión y escalado de la infraestructura en función de la demanda, eliminando la necesidad de gestionar servidores o pre-configurar la capacidad.

Para ilustrar cómo tomar un modelo de ML creado en SageMaker Canvas y desplegarlo utilizando SageMaker Serverless Inference, se puede seguir un flujo de trabajo que incluye varias etapas, desde añadir el modelo entrenado al registro de modelos de SageMaker hasta la creación de un endpoint sin servidor. Este enfoque permite pasar rápidamente de la creación del modelo a predicciones listos para producción sin gestionar ninguna infraestructura.

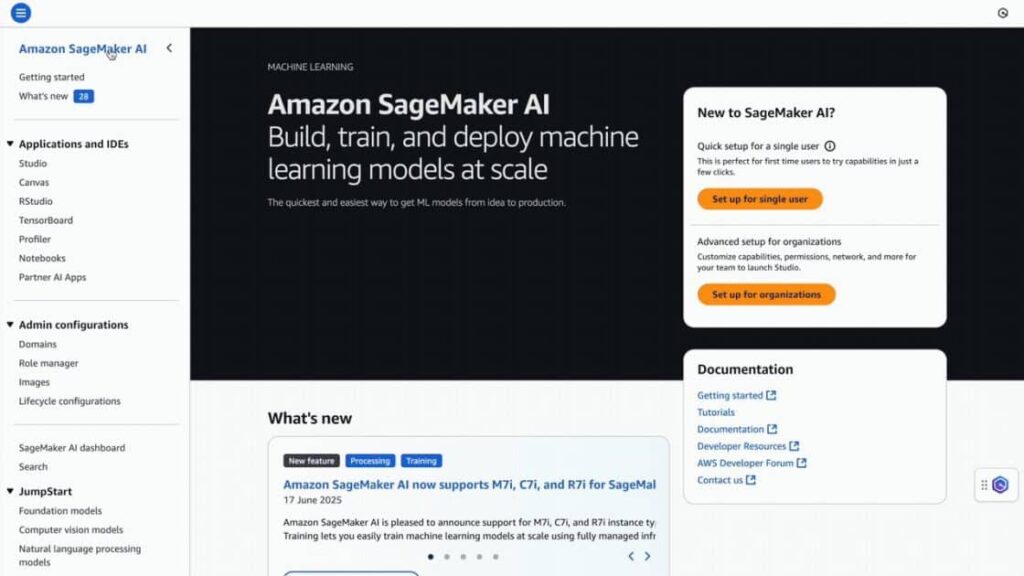

Los requisitos previos incluyen acceso a Amazon S3 y a Amazon SageMaker AI. Adicionalmente, se necesita un modelo de regresión o clasificación ya entrenado. Se procede a guardar el modelo en el registro de modelos de SageMaker y posteriormente a aprobar el modelo para su despliegue.

El proceso de creación de un nuevo modelo implica asignar un nombre al modelo, seleccionar la opción correcta del contenedor y agregar las variables de entorno necesarias. Posteriormente, se crea la configuración del endpoint y finalmente el endpoint.

Con esta arquitectura, las empresas pueden aprovechar una forma simplificada de implementar modelos de ML, lo que permite a organizaciones de diferentes tamaños y niveles técnicos desbloquear todo el potencial de la inteligencia artificial y el aprendizaje automático. Al utilizar estas herramientas, se minimiza la complejidad de la gestión de infraestructura, permitiendo que los equipos comiencen a recibir predicciones en poco tiempo y de forma efectiva.

vía: AWS machine learning blog