La inteligencia artificial generativa ha tomado protagonismo en el ámbito de la salud, impulsando una transformación digital significativa en áreas como la gestión del cuidado y el compromiso del paciente. Esta tecnología ha demostrado su capacidad para revolucionar la atención médica al permitir que los clínicos ofrezcan cuidados mejorados a través de sistemas automatizados y herramientas de apoyo diagnóstico que proporcionan sugerencias personalizadas y oportunas. Un estudio reciente destacó que los estudiantes de medicina que recibieron retroalimentación generada por modelos de lenguaje grande (LLM, por sus siglas en inglés) en simulaciones clinicas mejoraron notablemente su toma de decisiones clínicas en comparación con aquellos que no recibieron dicha retroalimentación.

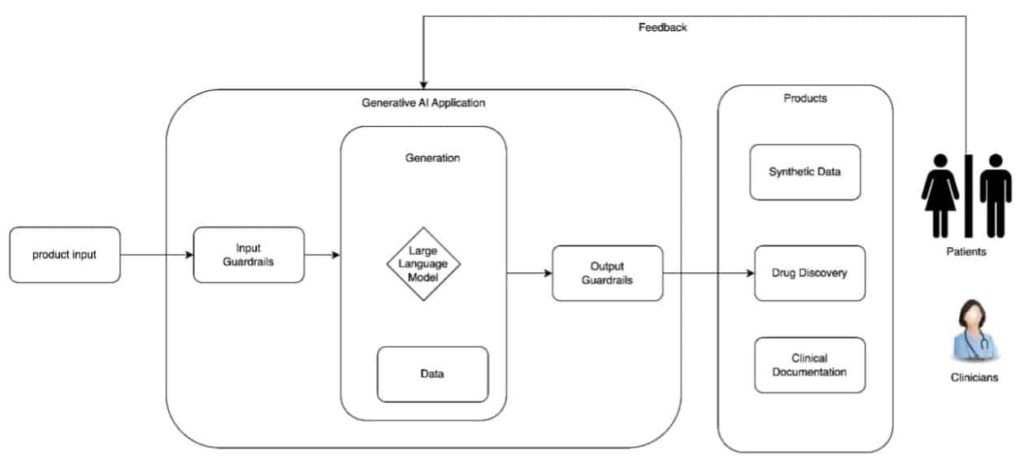

Los modelos de lenguaje grande son el núcleo de la mayoría de los sistemas de IA generativa, ya que permiten mantener conversaciones altamente naturales. Estos modelos habilitan la creación de productos en diversas áreas, desde la facturación y el diagnóstico hasta el tratamiento y la investigación, con la capacidad de operar de manera independiente bajo supervisión humana. Sin embargo, su utilización requiere una comprensión profunda de los riesgos y efectos que pueden tener sobre la prestación del servicio de salud, lo que significa que es necesario planear, definir y ejecutar un enfoque integral para desarrollar aplicaciones de IA generativa de forma segura y responsable.

Durante la fase de diseño de aplicaciones de IA generativa en salud, es fundamental establecer políticas de sistema que determinen los insumos y resultados. Estas políticas funcionan como pautas que, al ser cumplidas, ayudan a construir un sistema de IA responsable. Además, es crucial tener en cuenta los riesgos potenciales, como el de la confabulación —cuando el modelo genera respuestas erróneas pero confiadas— y el sesgo, que puede llevar a exacerbar desigualdades entre diferentes grupos.

Una parte esencial del desarrollo de aplicaciones de IA generativa es la transparencia y la responsabilidad a lo largo de su ciclo de vida. Esto implica documentar las fuentes de datos, las decisiones de diseño y las limitaciones a través de herramientas como las «fichas de modelo». Esta documentación no solo facilita la evaluación del sistema, sino que también permite a los usuarios finales tomar decisiones informadas sobre su uso.

Al diseñar sistemas de IA generativa, las mejores prácticas de seguridad deben integrarse en cada capa de la aplicación para proteger la privacidad de los pacientes y la seguridad de los datos. Estas aplicaciones pueden ser vulnerables a ataques adversariales, como la inyección de prompts. Para mitigar estos riesgos, se recomienda realizar evaluaciones de riesgo y establecer salvaguardias para controlar tanto las entradas como las salidas de los sistemas.

En conclusión, la IA generativa tiene el potencial de mejorar drásticamente diversos aspectos del cuidado de la salud mediante la mejora de la calidad del servicio, la experiencia del paciente y la seguridad clínica. Al diseñar y operar aplicaciones de IA, es vital considerar de manera sistemática las limitaciones y establecer un marco de gobernanza que garantice la seguridad y la confianza que los usuarios esperan.

vía: AWS machine learning blog