En un contexto donde las aplicaciones de inteligencia artificial generativa se integran en entornos de producción, la protección de datos sensibles se ha convertido en una prioridad. Esta integración plantea nuevos desafíos, especialmente en el manejo de información identificable de forma personal (PII). Un ejemplo claro se observa en las empresas de servicios financieros, donde diferentes equipos requieren acceso a datos de clientes, pero con distintos niveles de exposición y seguridad.

El equipo de servicio al cliente podría utilizar un asistente de inteligencia artificial para acceder a perfiles de clientes con el fin de ofrecer respuestas personalizadas, mientras que el equipo de análisis de fraude necesitaría dichos datos, pero sin recibir la información PII real. Este dilema resalta la necesidad de herramientas que permitan gestionar y proteger esta información sensible.

En respuesta a estos desafíos, Amazon ha desarrollado Bedrock Guardrails, una herramienta que ayuda a detectar información sensible en los pedidos de entrada y en las respuestas generadas por modelos. Este sistema permite a las organizaciones tener un control sobre el manejo de datos sensibles, ofreciendo opciones para bloquear o enmascarar información generada, lo que facilita el cumplimiento de las normativas de protección de datos.

Sin embargo, el uso de máscaras para proteger información sensible puede generar problemas adicionales, como la pérdida de reversibilidad de datos. Una vez que la información original es sustituida por un enmascaramiento genérico, esta se vuelve inaccesible para aplicaciones posteriores que podrían requerirla. Para abordar esta situación, la tokenización se presenta como una solución eficaz. A diferencia del enmascaramiento, la tokenización reemplaza los datos sensibles con tokens que son matemáticamente no relacionados con la información original, manteniendo intacta su estructura y usabilidad.

La integración de Amazon Bedrock Guardrails con servicios de tokenización permite a las organizaciones proteger los datos sensibles sin renunciar a la posibilidad de revertir los datos cuando sea necesario. Este enfoque resulta especialmente valioso para empresas en sectores altamente regulados que deben equilibrar la innovación con las obligaciones legales.

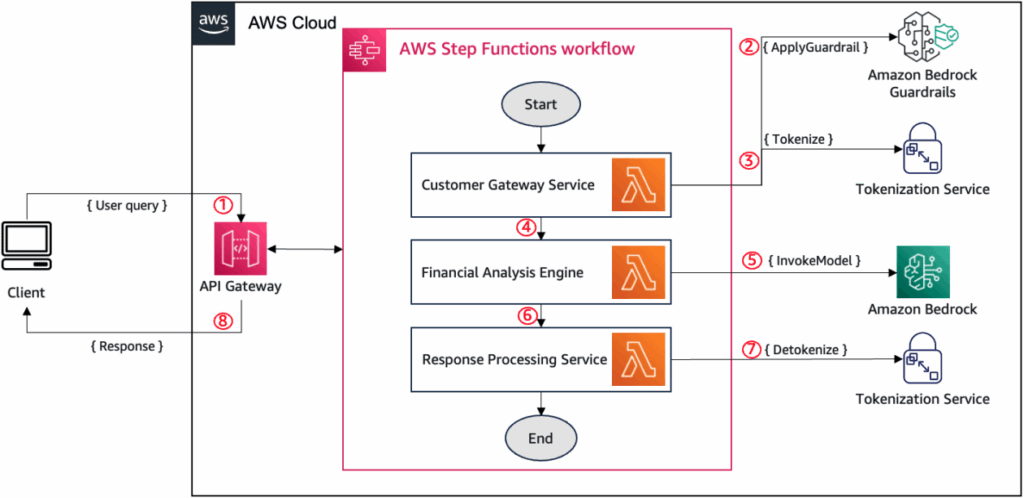

El proceso para implementar esta integración incluye varios componentes clave. Primero, se utiliza el API ApplyGuardrail para identificar información sensible en las entradas de usuario. Si se detecta PII, el sistema llama a un servicio de tokenización, que transforma los datos detectados en tokens antes de ser procesados por el modelo AI. Después, el resultado del modelo se somete a un nuevo control para asegurar que no contenga información sensible antes de ser enviado a otros sistemas.

Este flujo de trabajo, que combina las capacidades de Amazon Bedrock Guardrails con servicios de tokenización de plataformas como Thales CipherTrust, ayuda a las organizaciones a crear arquitecturas que protegen datos sensibles mientras permiten un procesamiento efectivo, asegurando así que se mantengan los estándares de seguridad y cumplimiento a lo largo del ciclo de vida de los datos.

vía: AWS machine learning blog