La evolución del machine learning (ML) ha transformado su etapa experimental en una herramienta esencial dentro de las operaciones comerciales. Hoy en día, muchas organizaciones están implementando modelos de ML para realizar pronósticos de ventas precisos, segmentaciones de clientes y predicciones de deserción. Aunque el ML tradicional sigue aportando mejoras significativas en los procesos de negocio, la inteligencia artificial generativa ha emergido como una fuerza revolucionaria, presentando herramientas accesibles que redefinen la experiencia del cliente.

A pesar de la creciente relevancia de la inteligencia artificial generativa, las soluciones de ML tradicionales son indispensables para ciertas tareas predictivas. Por ejemplo, el pronóstico de ventas, que se basa en el análisis de datos históricos y tendencias, es mejor gestionado por algoritmos de ML consolidados como bosques aleatorios, máquinas de gradiente, modelos ARIMA y redes de memoria a largo y corto plazo (LSTM). Asimismo, modelos de ML tradicionales como K-means y la segmentación jerárquica son ideales para la segmentación de clientes y la predicción de deserción. Mientras que la inteligencia artificial generativa demuestra capacidades excepcionales en tareas creativas como la generación de contenido y el diseño de productos, los modelos de ML tradicionales prevalecen en la generación de predicciones basadas en datos. La combinación de ambas aproximaciones puede resultar en soluciones que ofrezcan pronósticos precisos sin comprometer la eficiencia de costos.

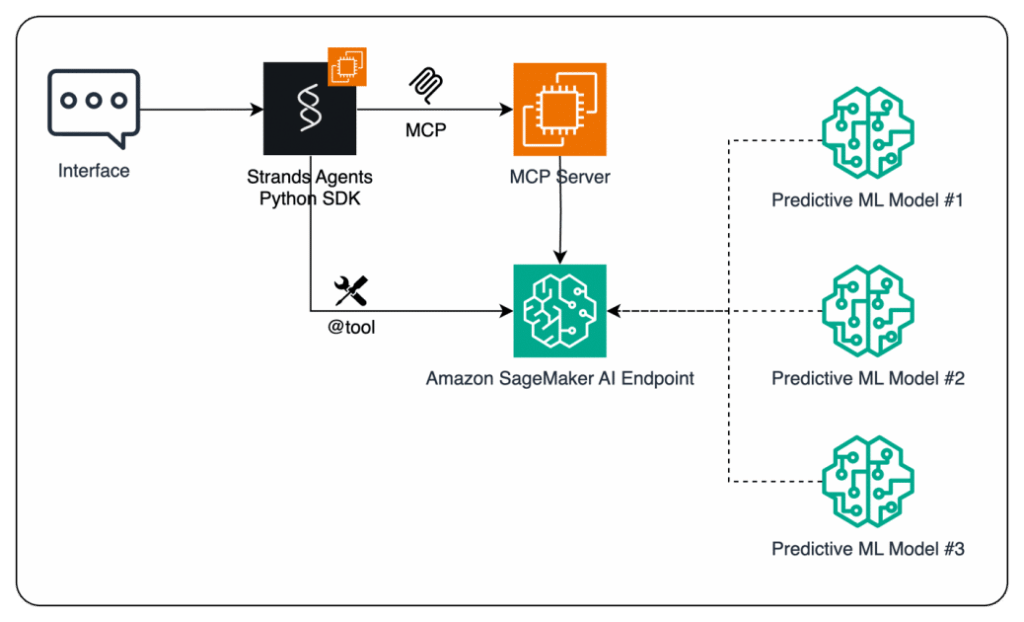

Con el fin de demostrar cómo las organizaciones pueden ampliar las capacidades de los agentes de inteligencia artificial mediante la integración de modelos predictivos de ML, se ha desarrollado un flujo de trabajo que permite que dichos agentes tomen decisiones informadas. Esta solución integra el Protocolo de Contexto de Modelo (MCP), un estándar abierto que define cómo las aplicaciones proporcionan contexto a modelos de lenguaje grandes (LLMs), a través de Amazon SageMaker AI.

Los agentes de inteligencia artificial desarrollados con el SDK de Strands Agents utilizan un LLM como su «cerebro» central, lo que les permite observar su entorno, planificar acciones y ejecutar tareas con mínima intervención humana. Esta integración permite a los agentes superar la simple generación de texto y actuar como entidades independientes que pueden tomar decisiones y llevar a cabo acciones orientadas a metas en diversos escenarios empresariales.

Para implementar esta solución, se presenta un proceso donde se entrena un modelo de pronóstico de series temporales utilizando Amazon SageMaker AI. Con la preparación de datos y la ingeniería de características adecuadas, se entrena un modelo como XGBoost para predecir valores de demanda futuros basados en patrones históricos. Posteriormente, se despliega el modelo en un endpoint de SageMaker AI, permitiendo accesos en tiempo real a través de llamadas a la API.

Al terminar el proceso, las predicciones generadas por el modelo son enviadas nuevamente al agente, que puede utilizarlas para mejorar la toma de decisiones y realizar acciones informadas. Esta arquitectura integral no solo proporciona un robusto fundamento para aplicaciones de inteligencia artificial, sino que también ofrece flexibilidad al permitir la elección entre el acceso directo a endpoints y una integración basada en MCP, adaptándose así a diversas necesidades empresariales.

Las organizaciones continúan buscando formas de hacer que sus agentes de inteligencia artificial sean más inteligentes y basados en datos, y la combinación de Amazon SageMaker AI, MCP y el SDK de Strands Agents se presenta como una solución poderosa para la creación de aplicaciones de próxima generación.

vía: AWS machine learning blog