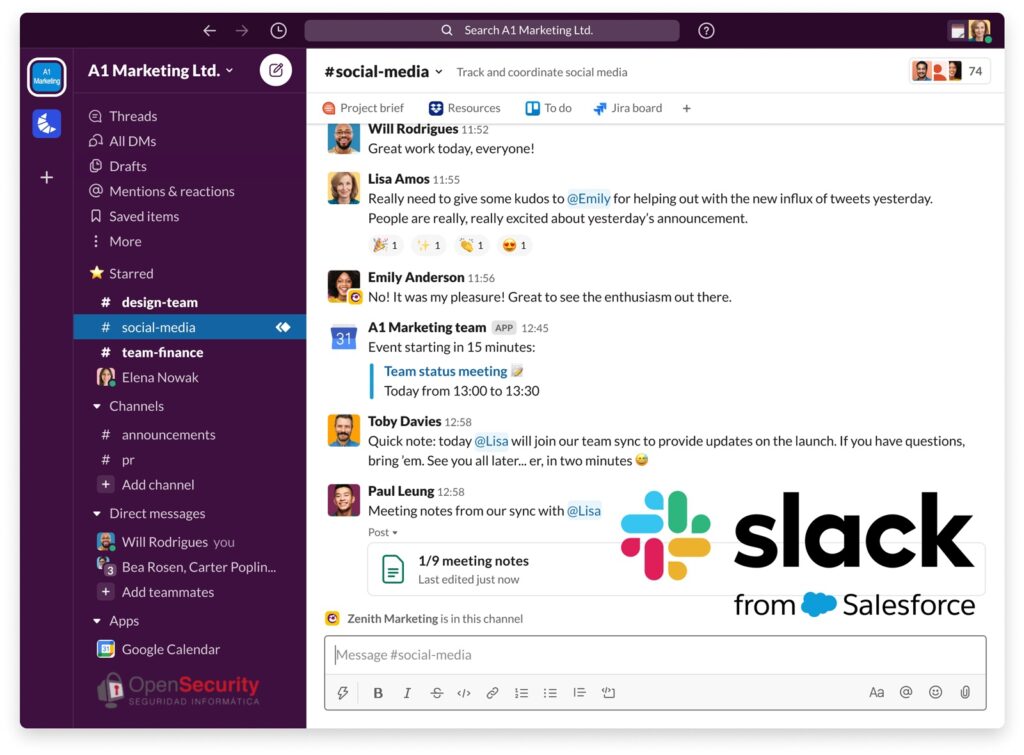

La polémica ha estallado entre los usuarios de Slack tras revelarse que la plataforma utiliza datos de sus mensajes, contenidos y archivos para entrenar modelos de inteligencia artificial (IA) de manera predeterminada. Esta noticia, que se ha difundido rápidamente por diversos foros y redes sociales, ha generado una fuerte reacción en la comunidad, y ha llevado a muchos a cuestionar las políticas de privacidad de Slack.

La Polémica de Slack AI

Desde el lanzamiento de Slack AI en febrero, la empresa ha defendido su política de recolección de datos, a pesar de las críticas. Esta política, que permite a Slack utilizar la información de los usuarios para entrenar sus modelos de IA, ha sido descrita como vaga y ha generado confusión y preocupación entre los usuarios.

Un artículo reciente de Ashley Belanger en Ars Technica ha recopilado las declaraciones y políticas conflictivas de Slack sobre sus prácticas de IA, pero la falta de claridad persiste. A pesar de los esfuerzos de varios medios por aclarar la situación, los usuarios siguen sin saber exactamente qué datos se están utilizando para entrenar estos modelos.

Reacciones en la Comunidad

La indignación no se ha limitado a los usuarios directos de Slack. La noticia ha resonado más allá de la comunidad de Slack, alcanzando a personas en foros y redes sociales que nunca han utilizado la plataforma, pero que ven en esta situación un reflejo de preocupaciones más amplias sobre la ética en el uso de la IA.

Uno de los puntos de comparación que se ha destacado es el uso de tecnologías generativas de IA en otros campos, como los videojuegos. Por ejemplo, el reciente juego de estrategia Stellaris ha integrado IA de manera ética y transparente, utilizando IA para la ideación de contenidos y generación de voces con el consentimiento informado de todos los involucrados.

Contraste con el Uso Ético de la IA

El director del juego Stellaris explicó cómo durante la fase inicial de ideación, se utiliza arte generado por IA para inspirar a los desarrolladores y artistas, pero ninguna de estas ideas iniciales llega al producto final sin una profunda intervención humana. Además, los actores de voz que contribuyeron al juego reciben regalías por sus líneas generadas mediante IA, un enfoque que asegura transparencia y respeto por los derechos de los involucrados.

Este ejemplo de Stellaris contrasta fuertemente con las prácticas de Slack y otras empresas como Copilot y OpenAI. En lugar de buscar el consentimiento de los usuarios y ser transparentes sobre el origen de los datos utilizados para entrenar sus modelos, estas empresas operan con poca claridad y justifican sus prácticas bajo la premisa de que la IA no puede funcionar sin apropiarse del trabajo de otros.

Llamado a la Acción

Para los usuarios de Slack, esta situación plantea serias preocupaciones sobre la privacidad y la seguridad de la información. Se recomienda que los usuarios insten a sus empleadores a optar por no participar en la recolección de datos para entrenamiento de IA de Slack, protegiendo así su información privada y datos corporativos.

La polémica en torno a Slack AI subraya la necesidad urgente de un debate más amplio sobre la ética en el uso de la inteligencia artificial, y la importancia de políticas transparentes y respetuosas con los derechos de los usuarios.